NSerega

Администратор

Ссылка на часть 1: https://forexsystemsru.com/threads/proof-of-stake-pos-perspektivy-i-problemy-chast-pervaja.91104/

Одна из главных задач статьи – детализация первого материала с помощью как конкретных примеров, так и теоретически синтезированных векторов атак.

Еще одна задача: доказательство на основе простого неравенства Profit(Attack) >> Costs(Attack) того факта, что современное PoS-семейство построено на посыле работы в 1) доверенной среде, где 2) стоимость взлома всегда меньше полученной от взлома прибыли, тогда как Web 3.0 – сплошь среда не доверенная, а взлом может иметь деструктивные начала.

Что уже написано по теме?

Из важных описаний на английском:

1. Криптовалюты без PoW. -https://arxiv.org/pdf/1406.5694.pdf

2. О консенсусе тендерминта. -https://tendermint.com/static/docs/tendermint.pdf

3. Почему PoS можно считать скамом (и нужно ли). -https://yanmaani.github.io/proof-of-stake-is-a-scam-and-the-people-promoting-it-are-scammers/

4. Решение проблем консенсуса через стейкинг монет. -https://download.wpsoftware.net/bitcoin/pos.pdf

5. Известнейший материал о сравнении PoS & PoW. -https://eprint.iacr.org/2014/452.pdf

6. Про PoS от исследователей Уроборос. -https://eprint.iacr.org/2018/378.pdf

В частности, в данной работе не рассмотрены следующие атаки:

1. Nothing-at-Stake («Ничего на кону»): о ее решении можно почитать -https://blog.ethereum.org/2014/11/25/proof-stake-learned-love-weak-subjectivity

а также:

а) в статье от 2015 года -https://blog.ethereum.org/2015/08/01/introducing-casper-friendly-ghost;

б) в разборе на medium. -https://medium.com/coinmonks/understanding-proof-of-stake-the-nothing-at-stake-theory-1f0d71bc027

2. Long distance attack («Атака издалека»).

3. An oligopoly of validators («Олигополия валидаторов»).

4. И многие иные популярные атаки.

Но «не рассмотрены» означает, что им не уделяется много внимания. Но не проговариваю вообще: все атаки в любой системе связаны и игнорировать любой вектор невозможно.

Еще хорошо знать следующие вещи:

1. Сетевой эффект – поскольку на нем строится концепт синтезированных атак. -https://ru.wikipedia.org/wiki/Сетевой_эффект

2. Теорема САР и трилемма блокчейна. -https://ru.wikipedia.org/wiki/Теорема_CAP

3. Классификацию сетевых атак. -https://ru.wikipedia.org/wiki/Удалённые_сетевые_атаки

Не то чтобы ничего не поймете, не зная обозначенных тезисов, но не все выводы покажутся очевидными: что, впрочем, не мешает общему восприятию.

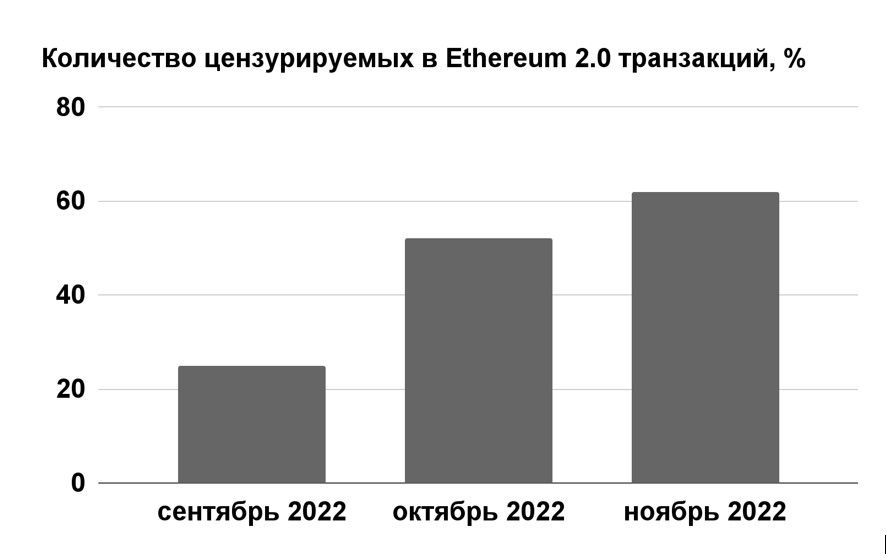

PoS. Краткая история ошибок за десять лет

Цензурированность блоков, централизация валидаторов, обманутые ожидания от TPS-фанатов – это и многое другое понятно в эпоху ETH2 и очередного краха Solana, в период крипто-зимы 2022, когда стейкхолдеры обновленного Эфира не знают, когда смогут получить средства, а такие же участники в Солана ждут очереди на выход, осознавая немыслимые потери.

Но все это экономический эффект от неумелого управления или же архитектурная проблема? Попробуем разобраться.

Если вспомнить, что задолго до ETH2 были: Peercoin, Nxt, BlackCoin, Novacoin, то станут очевидными следующие факты:

1) Поколений PoS несколько (как и PoW).

2) За не долгую эволюцию ряд проблем PoS-семейства были решены, а ряд, очевидно, нет.

Если для вас ничего очевидного в подобных выводах нет – продолжайте читать далее. Если есть – переходите к главе «Синтетические PoS-атаки».

Все перечисленные на абзац выше PoS-системы, равно как и родоначальник DPoS – Bitshares (Graphene), родились в период с 2012 по 2015 годы. И уже тогда была опубликована известная статья «Криптовалюты без Proof of Work» -https://arxiv.org/abs/1406.5694. То есть, что сказать и как по этому поводу было у любого исследователя с самого начала. И да, это не просто текст: это обобщение через формулы и родовые понятия, то есть даже простая детализация спокойно увеличит объем в 10 раз. Запомним это и пока – двинемся дальше.

Фактически вся история PoS до дня сегодняшнего – попытка или ускорить системы, или достичь нужных цифр в финализации, но при этом ни DPoS, ни LPoS, ни PoS2, никакой другой PoS до сих пор не решает главного:

Почему? Да потому как архитектура для этого не предназначена: есть робкие попытки синтеза: навроде PoH + PoS, PoW + PoS и так далее. Но, как убедились ранее и подтвердим опасения ниже – это работает обычно еще хуже.

Отчего же? Оттого, что если скрестить лошадь и автомобиль, то нечто красивое, удобное и надежное получится лишь в мультфильме, но не в реальной жизни.

Тогда возникает самый главный вопрос: «Почему же до сих пор так мало атак на PoS-семейство?» Ответ очевиден и дан мной не раз: пока они не были массовы (по LTV, количеству HODL-владельцев и так далее) – они не были интересны.

Синтетические PoS-атаки

Если коротко, то:

1. Бывают архитектурные атаки – или стратегические.

2. Атаки на технологию – или тактические.

3. Атаки на имплементации архитектуры и технологии – или операционные.

Первый тип атак касается всего PoS-семейства, вторые – подсемейств, а последние – только отдельных блокчейнов (не обязательно даже связанных).

Стратегические атаки

Прежде всего надо принять во внимание два тезиса.

Во-первых, цель алгоритма консенсуса, в общем случае, состоит в том, чтобы позволить безопасное обновление состояния в соответствии с некоторыми определенными правилами перехода состояния, где право на выполнение переходов состояния распределено между некоторым экономическим множеством. -https://blog.ethereum.org/2014/11/25/proof-stake-learned-love-weak-subjectivity

Во-вторых, экономическое множество – набор пользователей, которым может быть предоставлено право коллективно выполнять переходы через некоторый алгоритм. И важное свойство, которым должно обладать экономическое множество, используемое для консенсуса, заключается в том, что оно обязано быть безопасно децентрализованным. А это в свою очередь означает, что ни один субъект или сговор набора субъектов не может занять большинство в этом множестве, даже если этот субъект(ы) имеет достаточно большой капитал и финансовые стимулы.

Зная это – попробуем расширить спектр описываемых ранее атак.

Первичное деструктивное распределение

Если когда-нибудь пробовали классифицировать и как-то иначе препарировать атаки внутри ДРС (децентрализованных и/или распределенных систем), то наверняка заметили, что многие атаки – атаки на опережение:

1. Front running атаки и MEV-боты строятся на этом.

2. Манипуляции с flash-займами – тоже.

3. Эгоистичный майнинг.

4. И многие другие виды.

Одна из главных задач статьи – детализация первого материала с помощью как конкретных примеров, так и теоретически синтезированных векторов атак.

Еще одна задача: доказательство на основе простого неравенства Profit(Attack) >> Costs(Attack) того факта, что современное PoS-семейство построено на посыле работы в 1) доверенной среде, где 2) стоимость взлома всегда меньше полученной от взлома прибыли, тогда как Web 3.0 – сплошь среда не доверенная, а взлом может иметь деструктивные начала.

Что уже написано по теме?

Из важных описаний на английском:

1. Криптовалюты без PoW. -https://arxiv.org/pdf/1406.5694.pdf

2. О консенсусе тендерминта. -https://tendermint.com/static/docs/tendermint.pdf

3. Почему PoS можно считать скамом (и нужно ли). -https://yanmaani.github.io/proof-of-stake-is-a-scam-and-the-people-promoting-it-are-scammers/

4. Решение проблем консенсуса через стейкинг монет. -https://download.wpsoftware.net/bitcoin/pos.pdf

5. Известнейший материал о сравнении PoS & PoW. -https://eprint.iacr.org/2014/452.pdf

6. Про PoS от исследователей Уроборос. -https://eprint.iacr.org/2018/378.pdf

В частности, в данной работе не рассмотрены следующие атаки:

1. Nothing-at-Stake («Ничего на кону»): о ее решении можно почитать -https://blog.ethereum.org/2014/11/25/proof-stake-learned-love-weak-subjectivity

а также:

а) в статье от 2015 года -https://blog.ethereum.org/2015/08/01/introducing-casper-friendly-ghost;

б) в разборе на medium. -https://medium.com/coinmonks/understanding-proof-of-stake-the-nothing-at-stake-theory-1f0d71bc027

2. Long distance attack («Атака издалека»).

3. An oligopoly of validators («Олигополия валидаторов»).

4. И многие иные популярные атаки.

Но «не рассмотрены» означает, что им не уделяется много внимания. Но не проговариваю вообще: все атаки в любой системе связаны и игнорировать любой вектор невозможно.

Еще хорошо знать следующие вещи:

1. Сетевой эффект – поскольку на нем строится концепт синтезированных атак. -https://ru.wikipedia.org/wiki/Сетевой_эффект

2. Теорема САР и трилемма блокчейна. -https://ru.wikipedia.org/wiki/Теорема_CAP

3. Классификацию сетевых атак. -https://ru.wikipedia.org/wiki/Удалённые_сетевые_атаки

Не то чтобы ничего не поймете, не зная обозначенных тезисов, но не все выводы покажутся очевидными: что, впрочем, не мешает общему восприятию.

PoS. Краткая история ошибок за десять лет

Цензурированность блоков, централизация валидаторов, обманутые ожидания от TPS-фанатов – это и многое другое понятно в эпоху ETH2 и очередного краха Solana, в период крипто-зимы 2022, когда стейкхолдеры обновленного Эфира не знают, когда смогут получить средства, а такие же участники в Солана ждут очереди на выход, осознавая немыслимые потери.

Но все это экономический эффект от неумелого управления или же архитектурная проблема? Попробуем разобраться.

Если вспомнить, что задолго до ETH2 были: Peercoin, Nxt, BlackCoin, Novacoin, то станут очевидными следующие факты:

1) Поколений PoS несколько (как и PoW).

2) За не долгую эволюцию ряд проблем PoS-семейства были решены, а ряд, очевидно, нет.

Если для вас ничего очевидного в подобных выводах нет – продолжайте читать далее. Если есть – переходите к главе «Синтетические PoS-атаки».

Все перечисленные на абзац выше PoS-системы, равно как и родоначальник DPoS – Bitshares (Graphene), родились в период с 2012 по 2015 годы. И уже тогда была опубликована известная статья «Криптовалюты без Proof of Work» -https://arxiv.org/abs/1406.5694. То есть, что сказать и как по этому поводу было у любого исследователя с самого начала. И да, это не просто текст: это обобщение через формулы и родовые понятия, то есть даже простая детализация спокойно увеличит объем в 10 раз. Запомним это и пока – двинемся дальше.

Фактически вся история PoS до дня сегодняшнего – попытка или ускорить системы, или достичь нужных цифр в финализации, но при этом ни DPoS, ни LPoS, ни PoS2, никакой другой PoS до сих пор не решает главного:

«Большинство проблем с PoS-протоколами возникают из-за того, что протоколу не известно ничего, кроме соответствующего блокчейна. В системах доказательства работы присутствует внешний фактор, а именно количество вычислительной работы, которое требуется, чтобы найти решение. В системах с подтверждением доли отсутствуют факторы, закрепляющие блокчейн в физическом мире; поэтому интуитивно видно, что согласование на основе PoS допускает больше видов атак».

Почему? Да потому как архитектура для этого не предназначена: есть робкие попытки синтеза: навроде PoH + PoS, PoW + PoS и так далее. Но, как убедились ранее и подтвердим опасения ниже – это работает обычно еще хуже.

Отчего же? Оттого, что если скрестить лошадь и автомобиль, то нечто красивое, удобное и надежное получится лишь в мультфильме, но не в реальной жизни.

Тогда возникает самый главный вопрос: «Почему же до сих пор так мало атак на PoS-семейство?» Ответ очевиден и дан мной не раз: пока они не были массовы (по LTV, количеству HODL-владельцев и так далее) – они не были интересны.

Синтетические PoS-атаки

Если коротко, то:

1. Бывают архитектурные атаки – или стратегические.

2. Атаки на технологию – или тактические.

3. Атаки на имплементации архитектуры и технологии – или операционные.

Первый тип атак касается всего PoS-семейства, вторые – подсемейств, а последние – только отдельных блокчейнов (не обязательно даже связанных).

Стратегические атаки

Прежде всего надо принять во внимание два тезиса.

Во-первых, цель алгоритма консенсуса, в общем случае, состоит в том, чтобы позволить безопасное обновление состояния в соответствии с некоторыми определенными правилами перехода состояния, где право на выполнение переходов состояния распределено между некоторым экономическим множеством. -https://blog.ethereum.org/2014/11/25/proof-stake-learned-love-weak-subjectivity

Во-вторых, экономическое множество – набор пользователей, которым может быть предоставлено право коллективно выполнять переходы через некоторый алгоритм. И важное свойство, которым должно обладать экономическое множество, используемое для консенсуса, заключается в том, что оно обязано быть безопасно децентрализованным. А это в свою очередь означает, что ни один субъект или сговор набора субъектов не может занять большинство в этом множестве, даже если этот субъект(ы) имеет достаточно большой капитал и финансовые стимулы.

Зная это – попробуем расширить спектр описываемых ранее атак.

Первичное деструктивное распределение

Если когда-нибудь пробовали классифицировать и как-то иначе препарировать атаки внутри ДРС (децентрализованных и/или распределенных систем), то наверняка заметили, что многие атаки – атаки на опережение:

1. Front running атаки и MEV-боты строятся на этом.

2. Манипуляции с flash-займами – тоже.

3. Эгоистичный майнинг.

4. И многие другие виды.